创建一个视觉跟踪工程

这里我们要实现的功能是利用Guidance SDK中的API,通过USB从Guidance中读取图像数据,使用camshift完成一个视觉跟踪的应用。该教程支持Windows和Ubuntu系统。

demo文件夹中已经有了一个完整的视觉跟踪的工程,用户可以直接编译运行这个工程,以便有一个整体的认识。然后依照下面的指示,从零开始建立一个视觉跟踪的工程。

下载并解压SDK

你可以从GitHub下载到最新的Guidance SDK并解压。

内容包括:

- demo:一个基于Guidance SDK 的视觉跟踪应用

- doc: API说明文档

- examples: USB, UART及ROS的示例代码

- include: Guidance SDK头文件

- lib: Windows下库文件

- so: Linux下库文件

Windows

1. 新建guidanceSDK_test测试工程

如下图所示,在SDK/demo目录下创建自己的工程,这里在VS2010中创建了一个空工程,工程名为guidanceSDK_test。

![]()

2. 添加相应的.h及.cpp到工程

2.1 添加main.cpp

向工程中添加空的源文件main.cpp。

2.2 添加DJI_utility与DJI_utility.cpp

首先将要使用到的线程操作保护的源文件DJI_utility.cpp与头文件DJI_utility.h复制到与main.cpp同目录下,并在项目中添加。DJI_utility.cpp与DJI_utility.h在demo及examples中均可找到。

- 在demo/sdk_tracking_camshift/camshift中的DJI_utility相关文件。

- 将DJI_utility文件复制到工程所在文件夹,并添加到guidanceSDK_test工程中:

![]()

![]()

2.3 配置头文件与链接库路径

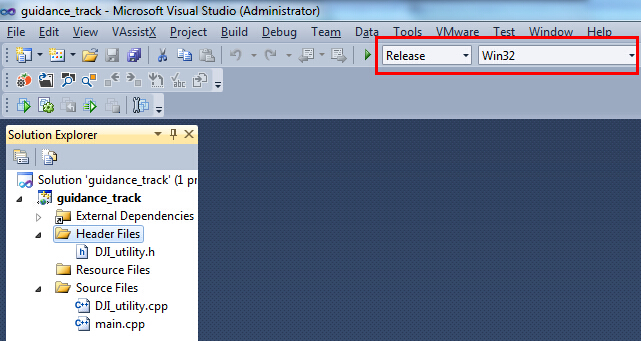

需要配置的有DJI_guidance.h、DJI_guidance.lib与OpenCV头文件及库文件的路径。 DJI_guidance.h头文件位于SDK/include中;DJI_guidance.lib位于SDK/lib中,在VS2010中需要进行相应的配置将它们的路径包含到工程中。由于本教程运行于Release Win32模式下,最后编译输出x86平台的release文件,对应的DJI_guidance.lib文件具体路径为SDK/lib/2010/x86。

- Visual Studio 2010工程为Release Win32模式:

- 在SDK/include中找到DJI_guidance.h并复制到工程目录。

- 在SDK/lib/2010/x86中找到DJI_guidance.lib并复制到工程目录。

- 将OpenCV相关的头文件和库文件目录添加到工程。

为简化配置的繁琐,可直接复制SDK/demo/sdk_tracking_camshift目录下的 “use_opencv_release_vs2010_x86.props” “use_Guidance_vs2010_x86.props” 文件到解决方案目录下并添加到工程。

- 在sdk_tracking_camshift工程目录中找到 “use_opencv_release_vs2010_x86.props” 和 “use_Guidance_vs2010_x86.props” 配置文件:

![]()

- 将相应的props配置文件拷贝到 解决方案目录下:

![]()

- 切换工具栏到 ”配置管理器”,右键单击Release | Win32,点击添加已有配置表 “Add Existing Property Sheet”,将工程目录下的 “use_opencv_release_vs2010_x86.prop” 与 “use_Guidance_vs2010_x86.prop” 这两个配置文件添加到工程中:

![]()

请注意:这里默认用户已按照环境配置中所述的方法,安装了Opencv2411,并正确添加了环境变量OPENCVROOT。这一环境变量在OpenCV的配置文件中被用到。

当工程路径变化时,用户也可以通过修改配置文件来适应;具体的可以查看相应的配置文件;这里给出一个Guidance相关文件配置的例子,OpenCV的配置类似。

- “use_Guidance_vs2010_x86.prop”中配置的头文件路径:

![]()

- “use_Guidance_vs2010_x86.prop”中配置的链接库路径:

![]()

3. 配置动态链接库文件

在SDK根目录下有lib文件夹,由于本教程中默认是VS2010建立的工程,并且运行Release Win32的程序,因此进入lib/2010/x86,将相应的DJI_guidance.dll文件复制出来。

![]()

4. 填入main.cpp代码

- 首先添加程序所需头文件。DJI_guidance.h中包含了Guidance API函数声明的头文件,必须添加;DJI_utility.h中包含了线程操作保护的头文件;OpenCV对应的头文件用于图像显示及视觉算法应用;

|

- 声明程序中需要用到的全局变量;其中image用作处理结果显示;g_lock是与线程操作保护有关的对象,g_event是与数据读取事件触发有关的对象,二者在DJI_utility.h中均有定义;selection用作鼠标选择跟踪目标;WIDTH, HEIGHT及IMAGE_SIZE宏定义为图像大小;

|

- 接着定义鼠标交互事件函数,该函数使得用户可以在图像传输开始时用鼠标框出要跟踪的目标;

|

- 再定义一个帮助函数,用来在Windows控制台模式下运行程序,如果输入

|

则会返回给用户程序使用方法;

|

本教程给出的是基于camshift算法与深度图的视觉跟踪demo,当程序开始运行用户需要首先使用鼠标在Guidance Tracking Demo窗口 中框出需要跟踪的目标,接着移动目标可以观察到跟踪效果;

![]()

- 然后定义一个回调函数,当订阅的数据到来时程序会自动调用该函数。用户应该只在回调函数中进行轻量级的处理,比如数据拷贝等,否则会降低数据传输频率。

|

- 当初始化、订阅或停止传输等操作失败时,返回为非0的int类型值,因此用户可以通过这些操作函数的返回值来判断失败的原因。我们这里宏定义两个操作,如果操作失败,则打印错误码或者直接终止程序;

- 在main函数中完成初始化、数据订阅、启动数据传输、图像处理显示、停止数据传输、释放传输线程等操作;

|

5. 编译运行

由于本教程默认guidance SDK运行所需的工作环境已经按照环境配置中配置成功,因此这里只需Build编译完工程,启动并通过USB线连接Guidance,点击Start Debugging即可运行程序。

Linux

1. 新建工程文件夹

- 将SDK包下载到

~/Desktop/GuidanceSDK目录。 - 新建工程目录

~/Desktop/SDK/demo/guidance_track,并添加DJI_utility.cpp 与 DJI_utility.h;另外main.cpp中的代码也与上一节Windows的介绍中相同,在此不赘述,直接拷贝过来。

|

![]()

2. 添加libDJI_guidance.so文件

由于本教程使用的是32位的Ubuntu14.04系统,因此去SDK根目录下的so/x86中,将libDJI_guidance.so文件复制到usr\local\lib 文件夹下即可,不同位数系统请复制对应的.so文件。请注意,复制时需要用到sudo权限。

|

3. 编写Makefile文件

接着编写Makefile文件。确保OpenCV已经正确安装。

|

Makefile代码如下:

|

4. 编译与运行

- 启动Guidance,并通过USB线将其与电脑连接。

- 编译并运行工程

|

- 当程序启动后,在“Guidance Tracking Demo”窗口中用鼠标框出待跟踪目标,接着可以在图上看到目标跟踪效果:

![]()

- 在该窗口上按

q键退出程序。